Bueno aca les dejo un tuto de como usar wget para transferencia y descarga de archivos desde el cmd.Espero q lo disfruten!!!

Descargar un archivo demasiado pesado (5GB, por ejemplo desde un sitio web):

# wget http://pagina.com/carpeta/grandistrolinux.iso

Pero… mientras estás descargando este archivo, repentinamente, puede

que haya un apagón y tu computador pierda el hilo de lo que ha

descargado, o momentáneamente el servidor desde donde lo estás bajando

se cae. En estos casos sería mejor utilizar wget así:

# wget -c http://pagina.com/carpeta/grandistrolinux.iso

Con la opción –c cualquier interrupción en la descarga será

“resumida” en otro intento de descarga. De hecho, si existe parte de un

archivo que se intentó descargar sin la opción –c, wget continuaría

descargando el archivo pero guardándolo con otro nombre:

grandistrolinux.iso.1.

Puedes también especificar el número de reintentos que hará wget

usando la opción --tries. Por ejemplo si quisiéramos que se el número de

intentos de descarga sea 8 podemos hacer lo siguiente:

# wget -c --tries=8 http://pagina.com/carpeta/grandistrolinux.iso

o

# wget -c -t 8 http://pagina.com/carpeta/grandistrolinux.iso

Incluso, podemos especificar el nombre del archivo resultante, es

decir, sino queremos que el archivo que descargamos tenga el nombre

grandistrolinux.iso sino ditro.iso,podemos hacer esto:

# wget -c --output-document=ditro.iso http://pagina.com/carpeta/grandistrolinux.iso

Pero wget no solo descarga archivos desde una página web, puede usar

también otros protocolos de comunicación, como por ejemplo FTP:

# wget -c --tries=10 ftp://pagina.com/carpeta/archivo.iso

Puedes cambiar el estilo en el que se muestra de forma gráfica el progreso de la descarga, así:

# wget -c --progress=dot http://pagina.com/carpeta/grandistrolinux.iso

También es posible configurar el límite de tasa de transferencia con

wget usando la opción --limit-rate, por

ejemplo si queremos limitarlo a 100.5K por segundo

# wget -c --limit-rate=100.5k http://pagina.com/carpeta/grandistrolinux.iso

de manera alternativa, la opción limit rate se puede usar con números+sufijos así:

# wget -c --limit-rate=1m http://pagina.com/carpeta/grandistrolinux.iso

Además, wget soporta el mecanismo de autenticación http y ftp y puede ser usado así:

# wget -c --user=usuario --password=contrasenia http://pagina.com/carpeta/grandistrolinux.iso

o

# wget -c --user=usuario --password=contrasenia ftp://72.29.83.102/archivo.odt

Puedes usar wget además, para enviar cookies a sitios que puedan requerirlo así:

# wget --save-cookie cookies.txt --post-data 'name=cris&passwd=cami' "http://unsitio.net/auth.php"

Y una vez autenticados con las cookies, como en ejemplo anterior, podemos proceder a descargar los archivos que necesitemos:

# wget --load-cookies cookies.txt -p http://unsitio.net/carpeta/algo.php

También es posible usar “recursión”. Si deseas descargar todos los

archivos desde una página web recursivamente usando wget, lo puedes

hacer así:

# wget -r "http://localhost/iniciaraqui/"

También podrías indicarle que no cree directorios, cuando está

realizando descargas de manera recursiva… lo cual solamente descargará

los archivos, así:

# wget -r -nd "http://localhost/iniciaraqui/"

Descargar los dos primeros niveles o más, de manera recursiva así:

# wget -r -l2 "http://localhost/iniciaraqui/"

Es posible usar además algo muy similar a Expresiones Regulares en

wget. Esto se hace usando los caracteres especiales * ?. Por ejemplo:

# wget http://localhost/*.txt

# wget ftp://dominio.com/pub/file??.vbs

# wget http://dominio.com/pub/files??.*

# wget -r "*.jpg" http://dominio.com/pub/

A la hora de descargar, por ejemplo, un fichero HTML… los links en

su interior podrían apuntar al dominio del cual se descargaron. wget

permite convertir los links dentro de los ficheros HTML, a enlaces que

apunten aarchivos locales. Esto es posible usando la opción

–k:

# wget -k http://localhost/wordpress/

Podemos además crear un archivo de log en wget, usando la opción –o, así:

# wget -c -o /var/log/archivolog http://localhost/archivo.txt

También puedes correr wget en background así:

# wget -b http://localhost/archivo.txt

O si usas GNU/Linux podría hacerse directamente desde la consola así:

# wget http://localhost/archivo.txt &

Una de las opciones que más me gustan de wget es la capacidad de

leer URLs de un archivo externo. Para aprovechar ésta función,

puedeshacer:

# wget -i Lista-URL.txt

Si usas wget como en el ejmplo anterior, no deberás escribir explícitamente la URL en la línea de comandos.

Puedes obligar a wget a usar IPv6 o IPv4 usando las opciones -6 y

-4, respectivamente. Además, puedes deshabilitar el caché y las cookies

usando las opciones --no-cache y

--no-cookies.

En cuanto a descargas a través de un Proxy, puedes indicarle el

usuario y password de autenticación usando las opciones

--proxy-user y

--proxy-password, así:

# wget --proxy-user=usuario --proxy-password=contrasenia URL

Adicionalmente, wget tiene soporte para HTTPS (SSL/TLS) usando los argumentos listados abajo:

--secure-protocol= (auto,SSLv2,SSLv3, TLSv1)

--certificate=archivo_certificado_cliente

--certificate-type= (PEM,DER)

--private-key=archivo_llave_privada

--private-key-type= (PEM,DER)

--ca-certificate=archivo_certificado

--ca-directory=directorio_fuente

La opción --no-parent necesita ser

especificada cuando se realicen descargas recursivas de tal manera que

se evite la búsqueda recursiva del directorio padre.

Puedes además usar redirección a archivos o tuberías (pipes) en GNU/Linux.

Y eso es todo, espero le sea de ayuda.

__________________________________________________________________________________

WGET, según wikipedia, es una herramienta de Software Libre que

permite la descarga de contenidos desde servidores web de una forma

simple. Entre las características más destacadas que ofrece wget está la

posibilidad de descargar fácilmente páginas web, pudiendo tener así una

copia de una página web completa en nuestro equipo.

Es un programa que soporta conexiones lentas o inestables, esperando

en el caso de que se corte la conexión a que se vuelva a restablecer

para continuar la descarga, etc. Y, además, soporta IPv6.

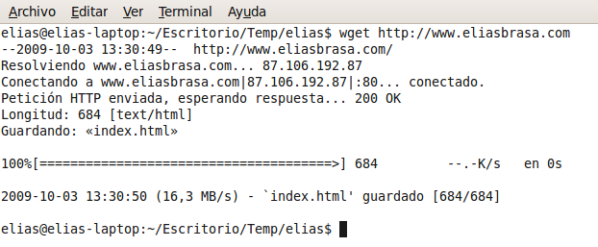

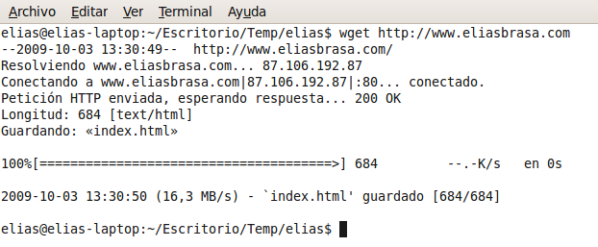

Lo más fácil es descargarnos la página principal de un sitio web:

wget http://www.eliasbrasa.com

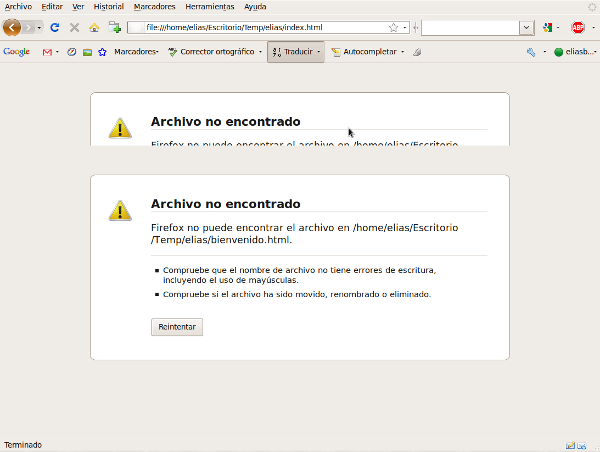

Con ese comando nos habremos descargado la página principal

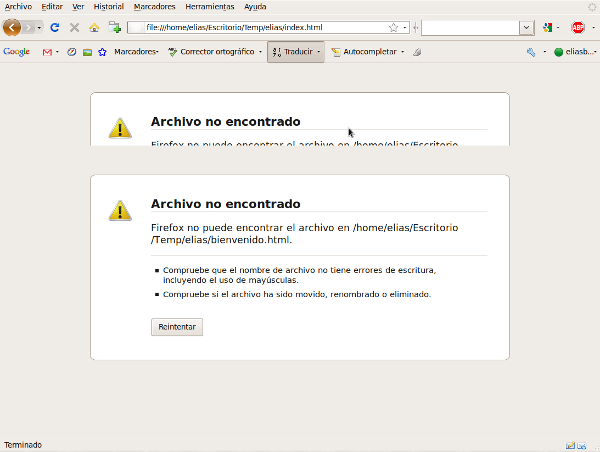

(index.html) de http://www.eliasbrasa.com PERO al intentar verla desde

nuestro ordenador, nos aparecerá algo como esto:

Esto es debido a que index.html tiene contenido que ha de estar junto

a él para poder visualizar la página web. Podremos descargarnos todo el

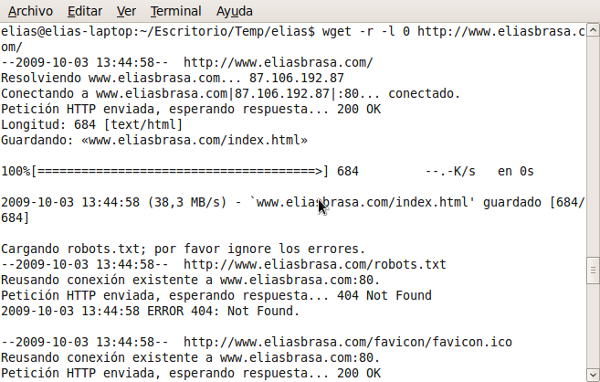

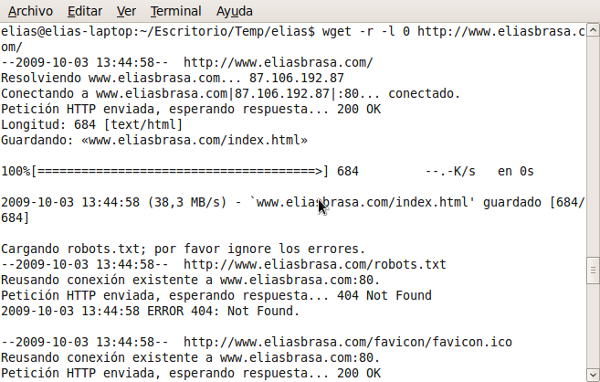

contenido con el comando:

wget -r -l 0 http://www.eliasbrasa.com/

Si nos da problemas, podremos descargarnos el contenido de una web completa haciéndonos pasar por un navegador:

wget -r -p -e robots=off -U mozilla http://www.eliasbrasa.com/

Si aún así nos sigue dando problemas, podremos establecer pausas

aleatorias para pasar totalmente desapercibidos como un navegador:

wget –random-wait -r -p -e robots=off -U mozilla http://www.eliasbrasa.com (delante de random hay dos guiones)

Lo que estamos haciendo es:

–random-wait significa que entre un pedido y otro al website, que espere

un tiempo aleatorio, para así no pedir demasiadas páginas y archivos

uno detrás de otro y alarmar a algún sistema de seguridad.

-e robots=off significa que wget no debe prestar atención al archivo

robots.txt que indica cuáles páginas no deben accederse por un navegador

web.

-r significa que queremos todo de manera recursiva.

-p indice que descargue todos los archivos para desplegar adecuadamente una página HTML.

-U mozilla significa que se haga pasar por un navegador de la familia Mozilla (como Firefox).

PARA REALIZAR DESCARGAS DESDE RAPIDSHARE CON WGET:

Lo primero que hay que tener en cuenta es que tenemos que tener una cuenta

premium

en rapidshare. Para poder realizar las descargas con Wget, accederemos a

nuestra cuenta premium y en el panel de configuración seleccionar la

opción de descargas directas.

Ahora lo que debemos hacer ahora es descargar la cookie que se

encargará de autenticar nuestra información cada vez que queramos

realizar una descarga. Creamos un directorio llamado cookies en nuestro

home:

mkdir ~/.cookies (Nota: Al ponerle el punto delante .cookies, el directorio se creará como oculto)

Ahora obtendremos la cookie:

wget –save-cookies

~/.cookies/rapidshare –post-data “login=USUARIO&password=CONTRASEÑA”

–no-check-certificate -O –

https://ssl.rapidshare.com/cgi-bin/premiumzone.cgi > /dev/null Pero sustituyendo USUARIO por nuestro usuario y CONTRASEÑA por nuestra contraseña. NOTA: delante de

save y de

no-check-certificate hay dos guiones.

Ahora cada vez que queramos realizar una descarga bastaría con ejecutar wget con el parametro

–load-cookies cookie, de la siguiente manera:

wget -c –load-cookies ~/.cookies/rapidshare URL (hay dos guiones delante de load-cookies y URL lo sustituiremos por la dirección web de la descarga)

Nota: También se usa el parámetro -c para continuar la descarga en caso de que haya sido interrumpida.

___________________________________________________________________________

Fuentes:http://norfipc.com/internet/wget.html

No hay comentarios:

Publicar un comentario